Lokale KI auf dem Mac – eine echte Alternative zum ChatGPT‑Abo?

Warum lokale KI?

Mit genügend RAM auf dem Mac und Tools wie LM Studio lässt sich KI lokal betreiben.

Das reduziert laufende Lizenzkosten, erhöht die Datenhoheit und macht unabhängig von Cloud‑Diensten.

Das reduziert laufende Lizenzkosten, erhöht die Datenhoheit und macht unabhängig von Cloud‑Diensten.

Hier findest du kostenfrei LM Studio → lmstudio.ai

Nachteile der lokalen Nutzung

- Kein Echtzeit‑Webzugriff: Das Modell arbeitet ohne Live‑Recherche.

- Keine direkten Screenshots/Uploads im Chat: Nur mit passenden multimodalen Modellen.

- Setup & Hardware: Modellwahl, RAM/GPU und Einrichtung liegen bei dir.

Möglichkeiten: Eigene API auf eigenem Server

- Integration: Nutzung gängiger OpenAI‑Clients (JS/Python) möglich.

- Netzwerkfähig: Per Portfreigabe/Proxy im LAN oder auf dem Server nutzbar.

- Kontrolle: Logging, Monitoring und Zugriffsschutz bleiben intern.

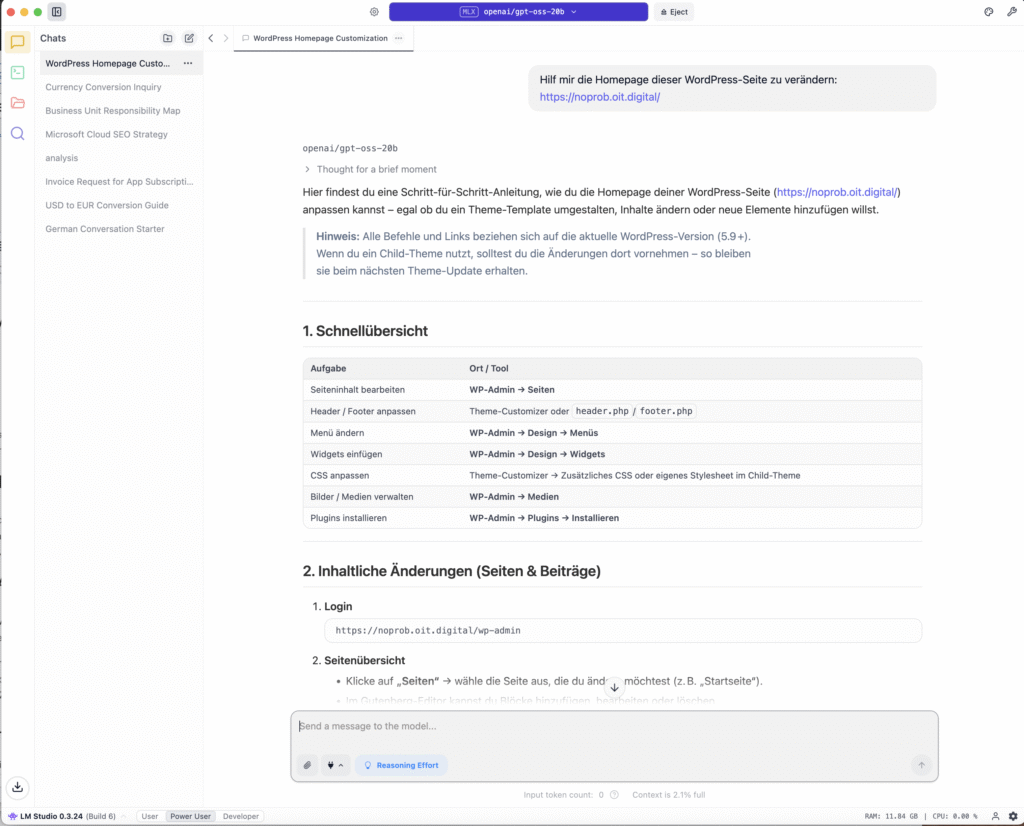

Was kann LM Studio zusätzlich?

- GUI & Katalog: Modelle (LLaMA, Mistral, Qwen, DeepSeek, Gemma) finden, laden, testen.

- RAG mit lokalen Dokumenten: Dateien einbinden und darauf basierend chatten.

- Multi‑Model‑Playground: Antworten verschiedener Modelle vergleichen.

- Multimodal (modellabhängig): Vision‑Funktionen, wenn unterstützt.

- Plattformen: macOS (Apple Silicon), Windows, Linux.

Modellempfehlungen & Gründe

Mistral 7B

Warum: Starkes Preis-Leistungs-Verhältnis, läuft flüssig bei moderatem RAM.

Einsatz: Assistenz-Tasks, E-Mails, kurze Texte, Code-Snippets.

LLaMA-Familie (z. B. 8B/13B)

Warum: Große Community, viele Quantisierungen GGUF verfügbar.

Einsatz: Ausgewogenes Sprachverständnis, breite Use-Cases.

Qwen / DeepSeek

Warum: Sehr gute Mehrsprachigkeit, starke Reasoning-Fähigkeiten in neueren Varianten.

Einsatz: Mehrsprachige Inhalte, strukturierte/analytische Aufgaben.

Gemma (teils multimodal)

Warum: Moderne Architektur, Bild-/Text je nach Variante.

Einsatz: Workflows mit Text und Bildern.

Quantisierte Varianten

Beispiele: Q4_K_M Q5 Q6_K

Warum: Geringerer RAM-Bedarf bei guter Qualität; ideal für Laptops/Mac Minis.

Hinweis: Höhere Quantisierung (Q6) ≈ bessere Qualität, aber mehr Speicher als Q4.

Vergleich: Lokal vs. ChatGPT‑Abo

| Aspekt | LM Studio (lokal) | ChatGPT (Abo) |

|---|---|---|

| Kosten | Keine laufenden Abos; Hardware einmalig | Monatliche Gebühren (z. B. Plus) |

| Datenhoheit | Bleibt intern/offline | Verarbeitung extern (Cloud) |

| Webzugriff | Kein Live‑Web (ohne Zusatzlösung) | Integrierte Web-/Browsing‑Funktionen |

| Bild/Screenshot | Nur mit passenden multimodalen Modellen | Bild‑Uploads je nach Plan möglich |

| Einrichtung | Setup & Modellmanagement nötig | Sofort nutzbar |

| Offline | Ja | Nein |

| Eigene API | OpenAI‑kompatible lokale REST‑API | Cloud‑API, extern betrieben |

| Hardwarebedarf | RAM/GPU erforderlich (modellabhängig) | Keine lokale Hardware nötig |

Fazit

Für Unternehmen mit sensiblen Daten, Entwicklerteams und Power‑Users ist LM Studio eine starke Alternative zum Cloud‑Abo. Wer Live‑Recherche, bequeme Bild‑Uploads und „Always‑Up‑to‑Date“-Modelle braucht, fährt mit einem ChatGPT‑Abo komfortabler.

ChatGPT: Sofort startklar, Web/Bilder & Updates – dafür laufende Kosten und externe Datenverarbeitung.

LM Studio: Kostenkontrolle, Datenhoheit, offline & eigene API – aber kein Live‑Web und Setup-Aufwand.

Wir helfen dir!

Du willst lokale KI testen oder eine eigene API aufsetzen?

Eric Fischer, IT Architecture Consultant

Dein Ansprechpartner für KI in Osnabrück

Sprich uns an – wir unterstützen bei Hardware‑Sizing, Modellwahl und Integration in deine Workflows.